Alerta: Uso de Inteligencia Artificial en Estafas Vocales

- Escrito por Redacción

- ¡Escribe el primer comentario!

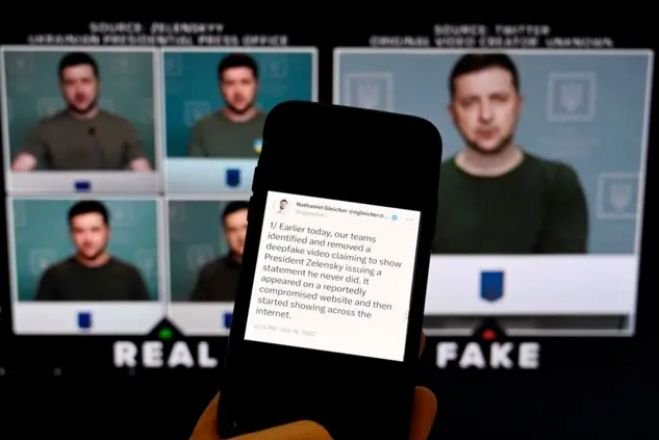

En un mundo cada vez más digitalizado, la inteligencia artificial (IA) se ha convertido en una herramienta poderosa y, lamentablemente, también en un recurso para la delincuencia. Recientemente, se han reportado casos preocupantes en los que delincuentes han utilizado tecnología de clonación de voz para estafar a personas, haciendo creer que están recibiendo una llamada de un familiar.

Esta técnica consiste en grabar y analizar la voz de una persona, generalmente a través de redes sociales o conversaciones previas, para crear un modelo que imita su tono, inflexiones y cadencias. Una vez que los estafadores tienen esta imitación convincente, llaman a la víctima haciéndose pasar por el familiar, frecuentemente solicitando ayuda financiera urgente. La urgencia y el familiaridad en la voz pueden llevar a la víctima a actuar rápidamente, sin cuestionar la autenticidad de la llamada.

Las consecuencias de este tipo de estafas pueden ser devastadoras, no solo en términos económicos, sino también en la confianza y seguridad personal. Las víctimas, al darse cuenta de que han sido engañadas, experimentan un profundo sentimiento de traición y vulnerabilidad.

Por ello, es crucial estar alerta y seguir algunas recomendaciones para protegerse:

-

Verificación Directa: Si recibes una llamada solicitando ayuda, verifica la situación directamente con el familiar a través de un medio diferente, como un mensaje de texto o una llamada desde otro número.

-

Desconfianza ante Urgencias: Los delincuentes a menudo crean situaciones de urgencia. Si algo suena demasiado alarmante, tómate un momento para pensar y verificar.

-

Educación sobre IA: Infórmate sobre cómo funciona la tecnología de clonación de voz y mantente al tanto de las nuevas tácticas que los delincuentes pueden emplear.

-

Uso de Redes Sociales: Ten cuidado con la información personal que compartes en redes sociales, ya que puede ser utilizada por estafadores para crear perfiles más creíbles.

-

Alertar a Otros: Comparte esta información con familiares y amigos para aumentar la conciencia y reducir la posibilidad de que otros caigan en estas trampas.

En resumen, aunque la inteligencia artificial tiene el potencial de mejorar muchos aspectos de nuestra vida, también puede ser utilizada de manera maliciosa. Mantente alerta y cuida de ti y de tus seres queridos. No dejes que la tecnología se convierta en un medio de manipulación y estafa.

Artículos relacionados (por etiqueta)

Lo último de Redacción

- Hombre es hallado sin vida frente a la plaza de toros La Coleta

- Hallan sin vida a trabajadora de la Fiscalía en Ocosingo

- Eduardo Ramírez inaugura la rehabilitación del Libramiento Sur de Tapachula

- Operativo integral en Cintalapa, permite detención de 9 personas por delito contra la salud en Cintalapa: FGE

- Incendio consume vivienda en la colonia Retiro San Martín